技术分享

3DGS:革新自动驾驶仿真场景重建的关键技术

随着自动驾驶技术的迅猛发展,构建高保真、动态的仿真场景成为了行业的迫切需求。传统的三维重建方法在处理复杂场景时常常面临效率和精度的挑战。在此背景下,3D高斯点阵渲染(3DGS)技术应运而生,成为自动驾驶仿真场景重建的关键突破。

一、3DGS技术概述

3DGS是一种基于3D高斯分布的三维场景表示方法。通过将场景中的对象转化为多个3D高斯点,每个点包含位置、协方差矩阵和不透明度等信息,3DGS能够精确地表达复杂场景的几何形状和光照特性。

与传统的神经辐射场(NeRF)方法相比,3DGS在渲染速度和图像质量方面表现出色,弥补了NeRF在动态场景处理和细节保留上的不足。

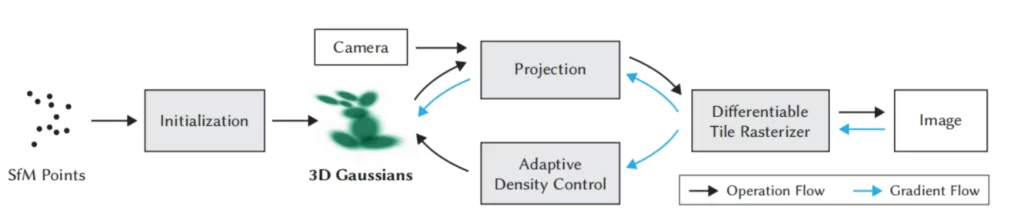

图1:3DGS重建流程

二、3DGS技术原理

在3DGS中,首先通过SfM(Structure from Motion)技术进行数据预处理,校准相机位置并恢复其内部和外部参数,生成稀疏点云。然后,基于这些点云初始化一组3D高斯点,每个高斯点的初始位置、协方差矩阵和不透明度都会进行设置。

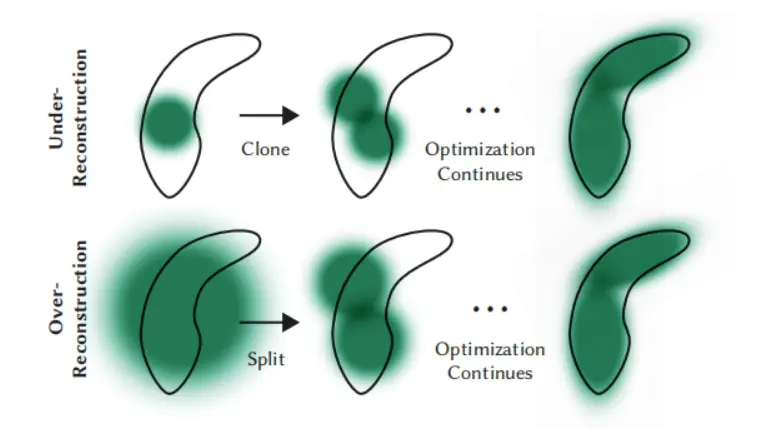

训练过程中,3DGS通过反向传播不断优化这些高斯点的位置、形状和不透明度。值得注意的是,3DGS采用了自适应密度控制,能够在每次反向传播后去除那些不重要的高斯点,并根据需要对高斯点进行分裂或克隆,以保证场景重建的精度和细节。

图2:训练过程中高斯点的优化

此外,3DGS还使用了一种基于瓦片的光栅化算法,将图像划分为16×16的瓦片,仅渲染每个瓦片中可见的高斯点,从而加速渲染过程。这种方法大大提高了训练速度,并支持实时渲染,使得3DGS在复杂场景的实时渲染中展现出了出色的表现。

三、3DGS在自动驾驶仿真中的应用

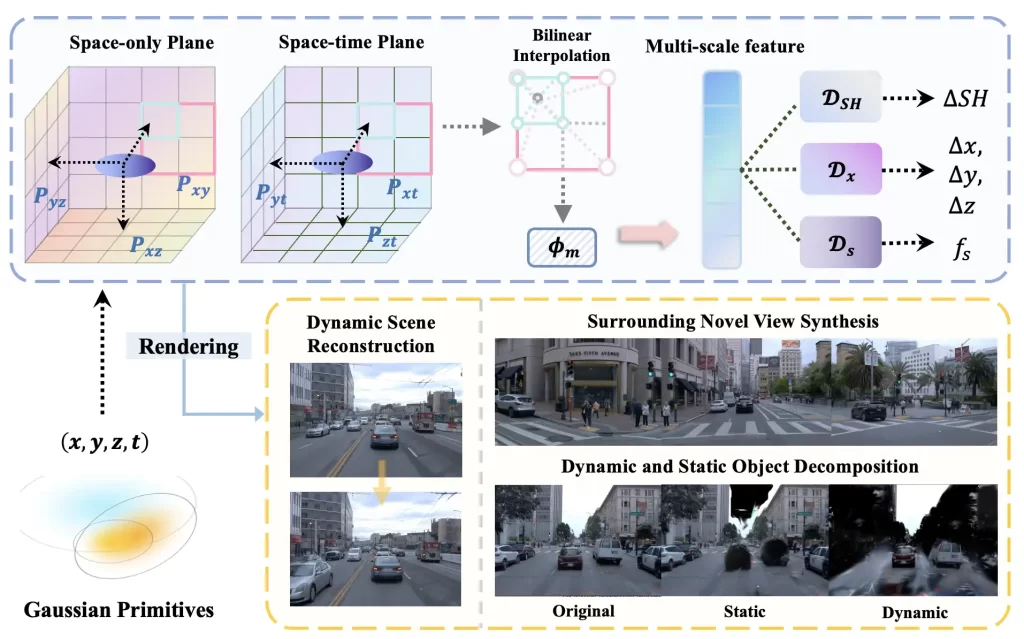

在自动驾驶领域,3DGS技术被广泛应用于高保真仿真场景的重建。通过将多视角图像转化为3D高斯点云,3DGS能够快速、精确地重建复杂的街道场景,为自动驾驶系统的训练和验证提供真实的虚拟环境。例如,Huang等人提出的S³Gaussian方法,通过自监督学习,从4D一致性中分解动态和静态元素,实现了高质量的街道场景重建。

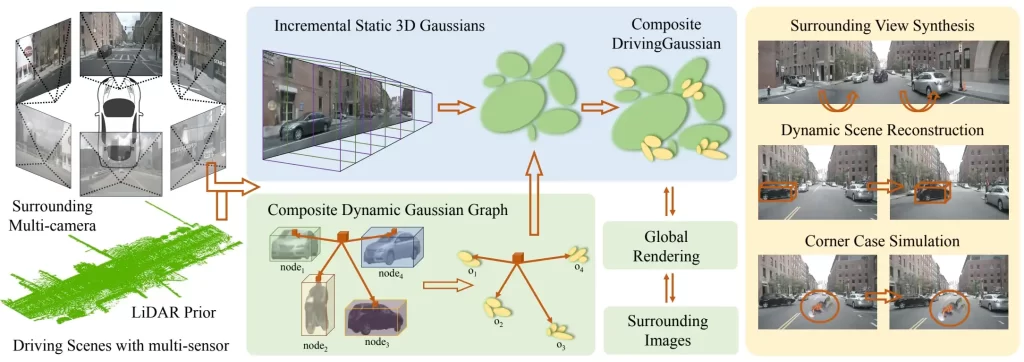

此外,Zhou等人提出的DrivingGaussian方法,针对环视动态自动驾驶场景,发展了基于3D高斯的重建仿真技术。该方法能够有效建模复杂的多尺度背景和前景,提升了自动驾驶系统在复杂环境下的感知能力。

其中,CVPR 2023 发表的 BEHAVE 数据集是第一个聚焦全身人-物体交互的大规模 3D 数据集。该研究通过多视角 RGB-D 采集与三维重建,精细还原了人类与日常物品之间的自然行为,包括动作接触点、物体遮挡、身体姿态等,为仿真平台构建乘员使用手机、饮水、与物体互动等细致行为场景提供了完整建模方案。

图3:S³Gaussian方法

在视线与注意力建模方面,ICCV 2019 的 Gaze360 提出了无需设备佩戴的 3D 凝视估计方法。该数据集涵盖不同光照和姿态条件下的大量受试者样本,引入时间建模与不确定性表达,为驾驶员注意力评估和视觉交互训练提供了更加贴近实际场景的支持,也使得 Anyverse 能够更加自然地模拟驾驶员在不同状态下的凝视方向和关注点。

图4:DrivingGaussian方法

1、3DGS的优势

- 高效性:通过显式建模方法,3DGS避免了传统神经网络训练中的计算开销,训练速度更快,渲染效率更高

- 精度:3D高斯点可以细致地捕捉场景中的每个细节,从而实现高精度的三维重建

- 实时性:3DGS支持实时渲染,适合需要快速响应的应用场景,如自动驾驶仿真

2、3DGS的挑战

- 场景复杂度:对于极为复杂的三维场景,3DGS可能需要大量的高斯点,这会增加计算负担和内存消耗

- 动态场景的支持:目前,3DGS主要集中在静态场景的重建,如何高效地处理动态场景中的物体变化,仍然是一个技术挑战