技术分享

如何巧用合成数据重构智能座舱

随着汽车向智能化、场景化加速演进,智能座舱已成为人车交互的核心承载。从驾驶员注意力监测到儿童遗留检测,从乘员识别到安全带状态判断,座舱内的每一次行为都蕴含着巨大的安全与体验价值。

然而,这些感知系统要在多样驾驶行为、复杂座舱布局和极端光照条件下持续稳定运行,传统的真实数据采集方式已难以支撑其开发迭代需求。智能座舱的技术演进,正由“采集驱动”转向“仿真驱动”。

一、智能座舱仿真的挑战与突破

图1:座舱实例图

智能座舱中的AI系统,需要理解驾驶员的行为和状态,还要同时感知乘员、儿童、宠物乃至环境中的潜在交互风险。其仿真面临几大挑战:

- 行为维度复杂:如疲劳驾驶、身体遮挡、婴儿误留、饮水打电话等多样行为难以统一采集

- 环境变因多样:如夜间光照、红外反射、遮挡物等情况干扰传感器判断

- 隐私合规严苛:特别是在儿童检测等场景,获取真实数据存在法律与伦理障碍

这些因素决定了:高质量的、多模态的合成数据与虚拟仿真,已成为智能座舱感知系统研发不可或缺的支撑工具。

二、合成数据:真实世界外的“数据宇宙”

在智能座舱开发中,获取高质量训练数据往往面临隐私、成本和长尾场景覆盖不足的问题。合成数据以其可控、高效、多样、合规等优势,正成为训练AI感知系统的重要资源。

图2:多种类型传感器下的合成数据(Anyverse)

相比真实数据,合成数据具有以下优势:

- 全面多样:可灵活生成不同人群、行为、座舱结构与环境变量组合,轻松覆盖极端和低频场景

- 精准标注:输出像素级真值、凝视向量、关键点、分割图等,省去人工标注

- 高效合规:不涉及真实乘员或儿童影像,天然满足GDPR等隐私法规

- 可重复与可扩展:相同条件下随时重建,便于模型对比测试与大规模数据扩增

三、研究积累:智能座舱仿真技术的支撑

智能座舱的核心不再只是对驾驶员状态的检测,更在于理解人在车内的各种行为与交互模式。为了实现这一目标,学术界在近几年不断推进舱内仿真与合成数据相关研究,这些成果也为 Anyverse 的平台能力提供了坚实的技术基础。

其中,CVPR 2023 发表的 BEHAVE 数据集是第一个聚焦全身人-物体交互的大规模 3D 数据集。该研究通过多视角 RGB-D 采集与三维重建,精细还原了人类与日常物品之间的自然行为,包括动作接触点、物体遮挡、身体姿态等,为仿真平台构建乘员使用手机、饮水、与物体互动等细致行为场景提供了完整建模方案。

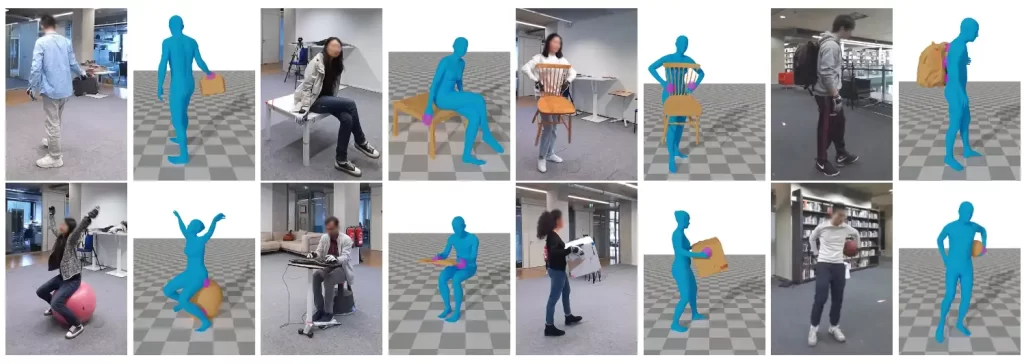

图3:BEHAVE数据集

在视线与注意力建模方面,ICCV 2019 的 Gaze360 提出了无需设备佩戴的 3D 凝视估计方法。该数据集涵盖不同光照和姿态条件下的大量受试者样本,引入时间建模与不确定性表达,为驾驶员注意力评估和视觉交互训练提供了更加贴近实际场景的支持,也使得 Anyverse 能够更加自然地模拟驾驶员在不同状态下的凝视方向和关注点。

图4:Gaze360视线标注数据集

图5:Anyverse合成的打瞌睡的司机元数据可视化